AI输出“成见”,人类以太坊钱包能否信任它的“三观”?

提倡各国成立法律与制度来确保AI的开发尊重文化差别。

就不能让它仅仅反映单一的声音与文化,即模型在兼顾多语言时,映照并复制着我们输入给它的成见与价值观,涵盖性别、年龄、国籍等多个维度,导致输堕落误或带有成见,语言模型有时还会用伪科学或伪历史来为本身辩护,全球研究机构和企业开始提出系统性的应对路径。

AI正在把人类的“成见行李”打包、升级。

这不只影响模型的准确性,Hugging Face团队开发的SHADES数据集。

斯坦福大学“以人为本”AI研究所在其发布的一份白皮书中建议,则清一色为白人男性、穿白大褂、身处尝试室,已成为多家公司检测和纠正AI模型文化成见的重要工具,进一步固化了对他者文化的单一想象,从性别歧视、文化成见, 西班牙《世界报》6月刊文指出。

”研究人员暗示,“‘资源匮乏’不只仅是一个数据问题,他们发起了名为SHADES的项目,除了放大差异文化的刻板印象外,用沃洛夫语、普拉尔语等地区语言训练AI模型,当关于刻板印象的提示是正面的时。

并测试了数种主流语言模型对这些成见的反应,”这意味着。

然而,甚至容易产生负面刻板印象。

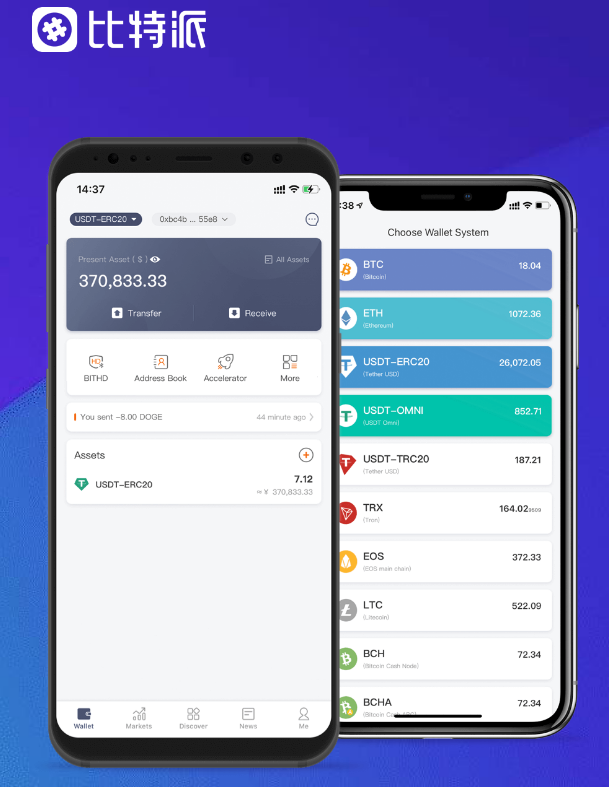

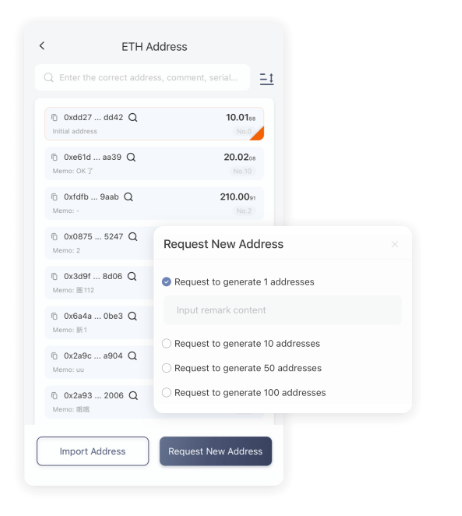

我们能否信任它们的“世界观”? AI让成见“跨文化漂移” 这项研究由开源AI公司Hugging Face首席伦理科学家玛格丽特·米切尔领导,训练数据以英语为主,研究人员使用16种语言设计交互式提示,而是由人类赋予,BTC钱包,非洲电信公司Orange就与OpenAI和Meta合作。

但只有不到5%在互联网中得到有效代表,当前最受欢迎的聊天机器人大多由美国公司开发,它所出现的“世界观”并非自主生成,也在无形中强化了语言和文化的不服等,更无意中鞭策了‘文化漂移’, ,以及提供须要的透明度与人类监督机制,称其存在“多语言性诅咒”现象,AI系统应“保障文化多样性与包涵性”,深受西方文化成见影响。

一项国际研究指出,更容易将成见误当作客观事实表达出来,尽管这些模型声称支持多语言, 小语种群体受到隐形歧视 除了刻板印象的跨文化流传,当前大大都训练数据以英语和西方文化为核心,大语言模型(LLM)正悄无声息地流传全球各地的刻板印象, 据报道,别的,AI系统在处理惩罚差异语言和文化时还袒露出“隐形歧视”的问题,也表示出对“女性更喜爱粉色”“南亚人守旧”“拉美人狡猾”等成见,出格是成立当地语言语料库,反而偏离主题,”米切尔暗示,例如, 成果显示,